La IRT en Evaluación: Aplicaciones y Avances

.

Por: Cristian Stiven Tarapues

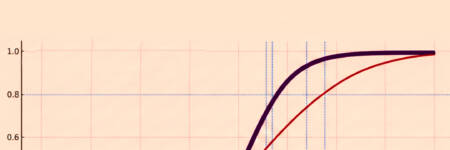

La Teoría de Respuesta al Ítem (Item Response Theory – IRT) representa un avance significativo en la medición psicométrica, al proporcionar un marco matemático que permite estimar habilidades y rasgos latentes con mayor precisión y robustez. A diferencia de la Teoría Clásica de los Tests (Classical Test Theory – CTT), que suele ofrecer estimaciones dependientes de la muestra y del conjunto específico de ítems, la IRT permite realizar estimaciones con mayor estabilidad al incluir un modelo matemático que considera la relación entre los ítems y los niveles de habilidad de los evaluados (Hambleton & Swaminathan, 1985).

Se utiliza ampliamente en la calibración de ítems y el análisis de pruebas, ayudando a que las mediciones sean menos susceptibles a las variaciones del grupo de prueba. Entre sus aplicaciones más destacadas se encuentran el desarrollo de pruebas estandarizadas, el análisis del funcionamiento diferencial de los ítems (DIF) para asegurar la equidad en las pruebas, la creación de bancos de ítems calibrados, la evaluación de competencias, y la validación de constructos psicológicos.

Aplicación de la IRT en el desarrollo de pruebas estandarizadas

La Teoría de Respuesta al Ítem (IRT) ha demostrado ser una herramienta invaluable en la educación, particularmente en el diseño y administración de pruebas estandarizadas a gran escala, este enfoque permite abordar tanto la creación de pruebas de alta calidad como la interpretación precisa y equitativa de sus resultados.

Por ejemplo, instituciones educativas a nivel nacional e internacional, como las responsables de los exámenes de ingreso a universidades o las evaluaciones de aprendizaje escolar, han implementado la IRT para garantizar que las pruebas sean justas y útiles. Este marco permite realizar comparaciones entre diferentes grupos de estudiantes o cohortes, incluso cuando las pruebas no son exactamente iguales en su contenido (Hambleton & Swaminathan, 1985).

En línea con lo anterior, una de las contribuciones más destacadas de la IRT es su capacidad para calibrar ítems de manera precisa, estimando parámetros como la dificultad, la capacidad de discriminación y el efecto del azar en las respuestas (en el caso del modelo de tres parámetros). Este proceso facilita la construcción de bancos de ítems sólidos y diversos, que a su vez permiten desarrollar nuevas versiones de pruebas con características equivalentes (Carlson & Davier, 2017).

Para ilustrar esta aplicación, consideremos un examen nacional en matemáticas que evalúa el razonamiento lógico de estudiantes de secundaria. La IRT no solo ayuda a seleccionar los ítems más apropiados para medir el razonamiento lógico en diferentes niveles de habilidad, sino que también permite garantizar que las preguntas sean igualmente desafiantes para todos los grupos, independientemente de su contexto geográfico o socioeconómico.

Otro aspecto importante de la IRT es su utilidad en contextos educativos diversos, donde es crucial que las pruebas reflejen adecuadamente las habilidades de los evaluados. Este enfoque permite crear ítems comparables en términos de dificultad y validez, evitando la necesidad de diseñar pruebas desde cero para cada aplicación. Por ejemplo, un banco de ítems bien diseñado podría ser adaptado tanto para medir habilidades en estudiantes de alto rendimiento como en aquellos con necesidades educativas especiales, sin comprometer la precisión ni la equidad de la medición (Hambleton, Swaminathan, & Rogers, 1991).

Aplicación de la IRT en el desarrollo de pruebas estandarizadas

La Teoría de Respuesta al Ítem (IRT) ha demostrado ser una herramienta invaluable en la educación, particularmente en el diseño y administración de pruebas estandarizadas a gran escala, este enfoque permite abordar tanto la creación de pruebas de alta calidad como la interpretación precisa y equitativa de sus resultados.

Por ejemplo, instituciones educativas a nivel nacional e internacional, como las responsables de los exámenes de ingreso a universidades o las evaluaciones de aprendizaje escolar, han implementado la IRT para garantizar que las pruebas sean justas y útiles. Este marco permite realizar comparaciones entre diferentes grupos de estudiantes o cohortes, incluso cuando las pruebas no son exactamente iguales en su contenido (Hambleton & Swaminathan, 1985).

En línea con lo anterior, una de las contribuciones más destacadas de la IRT es su capacidad para calibrar ítems de manera precisa, estimando parámetros como la dificultad, la capacidad de discriminación y el efecto del azar en las respuestas (en el caso del modelo de tres parámetros). Este proceso facilita la construcción de bancos de ítems sólidos y diversos, que a su vez permiten desarrollar nuevas versiones de pruebas con características equivalentes (Carlson & Davier, 2017).

Para ilustrar esta aplicación, consideremos un examen nacional en matemáticas que evalúa el razonamiento lógico de estudiantes de secundaria. La IRT no solo ayuda a seleccionar los ítems más apropiados para medir el razonamiento lógico en diferentes niveles de habilidad, sino que también permite garantizar que las preguntas sean igualmente desafiantes para todos los grupos, independientemente de su contexto geográfico o socioeconómico.

Otro aspecto importante de la IRT es su utilidad en contextos educativos diversos, donde es crucial que las pruebas reflejen adecuadamente las habilidades de los evaluados. Este enfoque permite crear ítems comparables en términos de dificultad y validez, evitando la necesidad de diseñar pruebas desde cero para cada aplicación. Por ejemplo, un banco de ítems bien diseñado podría ser adaptado tanto para medir habilidades en estudiantes de alto rendimiento como en aquellos con necesidades educativas especiales, sin comprometer la precisión ni la equidad de la medición (Hambleton, Swaminathan, & Rogers, 1991).

Funcionamiento diferencial de los ítems (DIF): El análisis del funcionamiento diferencial de los ítems (DIF, por sus siglas en inglés) es una herramienta esencial dentro de la Teoría de Respuesta al Ítem (IRT) para garantizar la equidad en las evaluaciones. Este enfoque permite evaluar si un ítem presenta un comportamiento distinto para diferentes grupos de personas (por ejemplo, según género, etnia o idioma nativo), incluso cuando estos grupos tienen niveles similares de habilidad en la competencia evaluada. Identificar estos sesgos es crucial para construir pruebas que sean justas y válidas, y la IRT ha sido fundamental en este proceso (Holland & Wainer, 2012).

Consideremos una evaluación de comprensión lectora que incluye un texto sobre béisbol. En este caso, aunque dos estudiantes tengan el mismo nivel de comprensión lectora, el ítem podría resultar más fácil para estudiantes de países donde el béisbol es un deporte popular (como Estados Unidos o Japón) en comparación con estudiantes de países donde este deporte es menos común (como India o Colombia).

Por ende esto ocurriría porque la familiaridad con el contexto y el vocabulario específico del béisbol influiría en la capacidad para responder correctamente, más allá de la habilidad de comprensión lectora que se pretende medir, el análisis DIF permitiría identificar este sesgo cultural y sugeriría la necesidad de modificar el texto o utilizar un contexto más universal para garantizar una medición más precisa de la comprensión lectora. Por lo tanto este enfoque fomenta la inclusión cultural y asegura que las pruebas reflejen fielmente las competencias reales de los evaluados.

Generación de informes: Otro aspecto que distingue a la IRT de los métodos tradicionales de evaluación es su capacidad para generar informes detallados y útiles, a diferencia de enfoques más simples que ofrecen únicamente puntajes brutos o percentiles, la IRT permite reportar resultados en escalas continuas de habilidad. Esto ofrece a los educadores y responsables de políticas una visión más rica y matizada del desempeño de los estudiantes (Kolen & Brennan, 2014). Por ejemplo, en una evaluación de competencias matemáticas, mientras un enfoque tradicional podría simplemente indicar que un estudiante obtuvo 7/10 puntos, la IRT puede proporcionar información mucho más específica. Puede indicar que el estudiante domina con seguridad operaciones con fracciones y decimales (nivel avanzado), está en proceso de desarrollo en álgebra básica (nivel intermedio), pero necesita refuerzo en geometría espacial (nivel básico). Esta información permite a los docentes diseñar intervenciones pedagógicas específicas para cada área de conocimiento, facilitando un apoyo más personalizado y efectivo en el proceso de aprendizaje.

Aplicación de la IRT en evaluación de conocimientos y competencias

La Teoría de Respuesta al Ítem (IRT) ha ganado un amplio reconocimiento en el ámbito de la evaluación de conocimientos y competencias debido a su enfoque riguroso. En el campo de la certificación profesional, desempeña un papel fundamental en el diseño de exámenes que evalúan los conocimientos y habilidades necesarios para ejercer de manera competente en áreas como medicina, enfermería, contabilidad, ingeniería, entre otras (Lane & Raymond, 2022). Este enfoque permite construir y mantener bancos de ítems de alta calidad, así como ensamblar formas equivalentes de exámenes, garantizando una evaluación justa y precisa.

Además de asegurar la equidad en los exámenes, la IRT también mejora la eficiencia en la administración de las pruebas, permitiendo generar exámenes equivalentes de forma rápida y confiable, lo que es crucial para organizaciones que necesitan realizar evaluaciones continuas, como las certificaciones periódicas en profesiones reguladas, esto, a su vez, facilita la gestión del personal certificado, asegurando que las evaluaciones sean válidas en cualquier momento o contexto en que se apliquen.

Dentro de las organizaciones, también se utiliza ampliamente para evaluar las competencias laborales y profesionales de los empleados y candidatos, estas evaluaciones pueden medir habilidades técnicas, de liderazgo, resolución de problemas y otras competencias clave para la selección de personal, capacitación y desarrollo profesional (Putka & Hoffman, 2014). De esta forma, facilita a las organizaciones diseñar programas de capacitación específicos y detectar brechas de habilidades de manera más efectiva, siendo especialmente útil en sectores dinámicos donde las competencias laborales pueden cambiar rápidamente.

Introduciendo a una de las innovaciones más destacadas en la aplicación de la IRT se podría mencionar a los tests adaptativos informatizados (TAI por sus siglas en inglés). En estas pruebas, los ítems se presentan de manera dinámica al examinado, seleccionando el siguiente ítem en función de las respuestas anteriores. Este enfoque optimiza la precisión de la medición y reduce el tiempo de prueba (Choi & Swaminathan, 2019). Por lo cual se ha empleado de manera eficiente para la selección de ítems y la estimación de habilidades, lo que las convierte en una herramienta alternativa y moderna para la evaluación de conocimientos y competencias. Finalmente, el uso del IRT en los TAI permite ajustar la dificultad de la prueba en tiempo real según el desempeño del examinado, esto mejora la precisión de la evaluación y también reduce la carga cognitiva de los participantes al no tener que responder ítems demasiado fáciles o demasiado difíciles para su nivel. En consecuencia, lo hace especialmente útil en la certificación de competencias técnicas y profesionales, donde se requiere una evaluación rigurosa y eficiente de habilidades específicas.

Aplicación de la IRT en investigación y evaluación básica

En el ámbito de la investigación y evaluación básica, la Teoría de Respuesta al Ítem (IRT) se ha consolidado como un enfoque indispensable para validar constructos, evaluar la equivalencia de medidas y construir escalas de medición confiables. Su versatilidad permite abordar diversos aspectos de la medición científica, aportando evidencia sólida para respaldar las conclusiones de las investigaciones.

Las aplicaciones clave en esta área incluyen:

Validación de constructos y modelos de medición: La IRT desempeña un papel fundamental en la validación de constructos y modelos de medición en diversas disciplinas, como la psicología, la educación y las ciencias sociales. Los investigadores pueden usarla para evaluar la unidimensionalidad de una medida, examinar la estructura interna de un constructo y probar modelos teóricos sobre las relaciones entre variables latentes y observables (Reise, Widaman, & Pugh, 1993). Por ejemplo, al examinar las evidencias de validez basadas en la estructura interna, se pueden identificar subgrupos de ítems o examinados con patrones de respuesta, lo que podría sugerir la presencia de diferentes dimensiones o facetas dentro del constructo.

Además, la IRT permite a los investigadores probar modelos teóricos sobre las relaciones entre variables latentes (constructos) y variables observadas (ítems). Pueden especificar modelos de ecuaciones estructurales que incluyen tanto variables latentes como observadas, posteriormente, pueden evaluar el ajuste de estos modelos utilizando técnicas avanzadas de IRT, como el análisis factorial confirmatorio y los modelos de ecuaciones estructurales con variables latentes (Glöckner-Rist & Hoijtink, 2003).

Estas técnicas permiten a los investigadores poner a prueba hipótesis específicas sobre las relaciones entre constructos teóricos, como la inteligencia, la motivación o la personalidad, y observar cómo estas variables latentes se manifiestan en las respuestas observadas a los ítems de una prueba. Los modelos IRT facilitan, además, el análisis del impacto de variables externas como el contexto socioeconómico, el género, la edad o el contexto educativo en la medición de los constructos de interés. Esto es particularmente útil en estudios donde factores externos pueden influir en el desempeño en la prueba.

Estudios de equivalencia de medidas entre grupos: Mediante técnicas como el análisis del funcionamiento diferencial del ítem (DIF), los investigadores pueden identificar y corregir posibles sesgos culturales, lingüísticos o de otro tipo en los ítems y establecer la invarianza de las mediciones a través de grupos (Millsap & Everson, 1993).

Además de identificar sesgos en los ítems, la IRT permite evaluar si los constructos medidos por una prueba son equivalentes entre distintos grupos. Este enfoque ayuda a los investigadores a garantizar que las puntuaciones obtenidas sean comparables entre personas de diferentes culturas, idiomas o grupos demográficos, asegurando que las diferencias observadas reflejan verdaderas diferencias en el rasgo medido, y no sesgos en los ítems.

Escalamiento de ítems y construcción de escalas: La IRT proporciona una base para el escalamiento de ítems y la construcción de escalas de medición, los ítems se calibran en una escala común de habilidad o rasgo latente, lo que permite una interpretación más significativa de las puntuaciones. Esto es especialmente útil en la creación de instrumentos de medición en áreas como la psicología clínica, la evaluación de la personalidad y la medición de actitudes (Embretson & Reise, 2000).

Esta teoría de medición también facilita el desarrollo de escalas de medición adaptadas a poblaciones específicas, mediante la calibración de ítems, los investigadores pueden identificar qué ítems funcionan mejor para ciertos grupos, mejorando la precisión de las mediciones y permitiendo que las escalas sean más sensibles a variaciones sutiles en las respuestas de los participantes.

Además, la IRT facilita la comparación de puntuaciones entre diferentes formas o versiones de una prueba, ya que los ítems se encuentran en la misma escala de medida. Esto permite un seguimiento más preciso del cambio o progreso en el rasgo latente a lo largo del tiempo o después de una intervención (Reise & Henson, 2003). Esta capacidad es particularmente valiosa en investigaciones longitudinales, donde es esencial medir los cambios en el tiempo con una alta fiabilidad.

Avances futuros en IRT y sus aplicaciones

A medida que avanzan las tecnologías y se amplían las aplicaciones de la IRT, se vislumbran diversos desarrollos futuros que prometen mejorar la precisión, flexibilidad y personalización de las evaluaciones.

- Modelos Multidimensionales

Aunque la IRT tradicional se centra en la unidimensionalidad, los modelos multidimensionales están ganando terreno en la investigación y práctica. Estos modelos permiten evaluar múltiples rasgos o habilidades simultáneamente, lo que es útil para pruebas que no pueden ser adecuadamente descritas con un solo factor. Investigaciones recientes han demostrado la aplicabilidad de estos modelos en áreas como la evaluación de competencias profesionales complejas o perfiles psicológicos integrales (Chalmers, 2018). En educación, por ejemplo, se están utilizando para evaluar simultáneamente diferentes dominios de aprendizaje, proporcionando una visión más exhaustiva del rendimiento del estudiante.

- Adaptación a Nuevas Tecnologías y Pruebas Informatizadas

Los tests adaptativos informatizados (TAI) están evolucionando hacia formatos más personalizados y dinámicos. Los avances en aprendizaje automático y análisis de big data están permitiendo que las pruebas adaptativas sean más precisas, ajustándose no solo al nivel de habilidad del examinado, sino también a su ritmo y estilo de respuesta. Estudios recientes han explorado la incorporación de elementos de gamificación en las pruebas adaptativas, mejorando la motivación y el compromiso de los participantes (Yan et al., 2014). Además, el uso de realidad virtual y aumentada en las evaluaciones está abriendo nuevas posibilidades para crear situaciones de evaluación más inmersivas y realistas.

- IRT y Análisis de Datos Masivos

La integración de la IRT con técnicas de big data está ofreciendo nuevas perspectivas sobre cómo las personas aprenden y trabajan. Investigaciones recientes han demostrado cómo el análisis de datos masivos con IRT puede ayudar a identificar patrones de aprendizaje y predecir el rendimiento futuro con mayor precisión (Wagino et al., 2023). En el ámbito laboral, estas técnicas se están utilizando para desarrollar sistemas de evaluación continua del desempeño, permitiendo intervenciones más oportunas y personalizadas.

- Incorporación de Factores Contextuales y Sociales

Los modelos IRT están evolucionando para incluir factores contextuales y sociales en la evaluación. Estudios recientes han explorado cómo incorporar variables como el entorno de aprendizaje, las interacciones sociales o la motivación en los modelos IRT (Thomas, 2019). Esto está permitiendo una medición más contextualizada y una mejor comprensión de cómo estos factores influyen en el rendimiento individual.

- Uso en Evaluaciones Psicológicas más Complejas

En psicología clínica, los avances en IRT están permitiendo el desarrollo de modelos no lineales y modelos híbridos que combinan IRT con otros enfoques estadísticos. Investigaciones recientes han utilizado estos modelos para crear escalas que miden no solo la severidad de los síntomas en trastornos mentales, sino también su dinámica y evolución en el tiempo (Markon, 2019). Esto está proporcionando una comprensión más profunda y matizada de los trastornos mentales complejos.

- IRT Bayesiana

El uso de la IRT Bayesiana continúa en auge, permitiendo la inclusión de información previa en el análisis y siendo particularmente útil en estudios con muestras pequeñas. Desarrollos recientes han demostrado la eficacia de los enfoques bayesianos en pruebas adaptativas y análisis en tiempo real, crucial en entornos digitales (Luo & Jiao, 2018). Además, se están explorando aplicaciones de IRT Bayesiana en la evaluación de constructos psicológicos complejos y en la personalización de intervenciones terapéuticas.

- Modelos de Respuesta Continua

Una tendencia emergente en el desarrollo de modelos IRT es su aplicación a datos de respuesta continua, como tiempos de reacción o medidas fisiológicas. Estos modelos están ampliando las posibilidades de evaluación en áreas como la neuropsicología y la psicología cognitiva (Van der Linden, 2019). A diferencia de los modelos tradicionales de IRT, que fueron diseñados para datos de respuesta discreta (como ítems dicotómicos o politómicos), los modelos de respuesta continua permiten analizar variables que se expresan en una escala continua, lo que abre nuevas oportunidades para estudiar procesos cognitivos y conductuales a nivel micro, por ejemplo, los investigadores pueden emplear estos modelos para explorar patrones de activación cerebral durante tareas cognitivas o para analizar perfiles de respuesta fisiológica relacionados con ciertos estados emocionales.

- IRT y Deep Learning (Aprendizaje Profundo)

La integración de la IRT con técnicas de aprendizaje profundo está abriendo nuevas posibilidades para el análisis de datos complejos, como respuestas de texto libre o datos de interacción en entornos virtuales. Tradicionalmente se ha aplicado principalmente al análisis de ítems de opción múltiple o respuesta dicotómica, sin embargo, el surgimiento de modelos de aprendizaje profundo, que incluyen redes neuronales y procesamiento de lenguaje natural, ha permitido a los investigadores expandir el alcance de la IRT más allá de los formatos de respuesta estructurados.

Las investigaciones recientes han explorado cómo la integración de estos enfoques puede mejorar la precisión y la capacidad de diagnóstico de las evaluaciones (Tsutsumi et al., 2021; Gardner et al., 2021). Por ejemplo, en entornos educativos digitales, el uso conjunto de redes neuronales e IRT puede ayudar a analizar patrones en las respuestas de los estudiantes a lo largo del tiempo. Esto permite desarrollar evaluaciones adaptativas que se ajusten al nivel de habilidad y al estilo de aprendizaje de cada individuo, ofreciendo una experiencia de evaluación más personalizada y significativa.

Además, la combinación de aprendizaje profundo e IRT abre la puerta al análisis de datos de respuesta más complejos, como textos libres o interacciones en entornos virtuales. Los modelos de aprendizaje profundo pueden interpretar el contenido y la estructura de las respuestas de manera semántica, permitiendo evaluar habilidades más avanzadas, como la capacidad de redacción, argumentación o comprensión lectora (Ke et al., 2019). Esto proporciona una evaluación integral del rendimiento de los evaluados, que va más allá de la mera precisión en las respuestas.

Por último, en aplicaciones como el aprendizaje personalizado y el diagnóstico en tiempo real, la integración del aprendizaje profundo y la IRT ofrecen nuevas oportunidades. Estos enfoques combinados pueden identificar patrones ocultos en los datos y predecir el rendimiento futuro de los evaluados (Li, Shuai, Hu, & Zhang, 2022). Esto facilita intervenciones educativas más precisas y ajustadas a las necesidades individuales, aprovechando las fortalezas de ambos enfoques que son: la capacidad de la IRT para realizar análisis psicométricos robustos y la habilidad del aprendizaje profundo para captar patrones complejos y no lineales en los datos.

Conclusión

A medida que la Teoría de Respuesta al Ítem (IRT) continúa evolucionando, su impacto en la investigación y la práctica seguirá creciendo exponencialmente. La IRT no solo ha mejorado significativamente la calidad de las evaluaciones, sino que también ha abierto nuevas y prometedoras vías para la investigación y la innovación, al modelar de manera más precisa la relación entre las características de los ítems y las habilidades latentes, la IRT ha permitido un nivel de sofisticación en la medición psicológica que antes era inimaginable.

Con miras al futuro, las tendencias emergentes como los modelos multidimensionales, la integración con tecnologías avanzadas y el análisis de datos masivos prometen ampliar aún más el alcance y las posibilidades de la IRT. Estas innovaciones no solo facilitarán evaluaciones más precisas y personalizadas, sino que también permitirán una comprensión más profunda de los factores contextuales y complejos que influyen en el rendimiento humano.

En conclusión, la IRT no es solo una técnica de evaluación, sino un pilar en la evolución de la medición psicométrica, adaptándose a las demandas cambiantes de un mundo en constante transformación, su capacidad para fusionar rigor estadístico y aplicabilidad práctica garantiza su relevancia como herramienta clave en la evaluación y el desarrollo.

Bibliografía

Choi, S. W., & Swaminathan, H. (2019). Application of item response theory in computerized adaptive testing. En W. J. van der Linden (Ed.), Computerized adaptive testing: Theory and practice (pp. 37-61). Springer. https://doi.org/10.1007/978-3-030-18480-3_3

Carlson, J.E., von Davier, M. (2017). Item Response Theory. In: Bennett, R., von Davier, M. (eds) Advancing Human Assessment. Methodology of Educational Measurement and Assessment. Springer, Cham. https://doi.org/10.1007/978-3-319-58689-2_5

Chalmers, R. P. (2018). Numerical approximation of the observed information matrix with Oakes’ identity for the multidimensional two-parameter logistic model. British Journal of Mathematical and Statistical Psychology, 73(1), 1-21. https://doi.org/10.1111/bmsp.12127

Edelen, M. O., & Reeve, B. B. (2007). Applying item response theory (IRT) modeling to questionnaire development, evaluation, and refinement. Quality of Life Research, 16(Suppl 1), 5-18. https://doi.org/10.1007/s11136-007-9198-0

Embretson, S. E., & Reise, S. P. (2000). Item response theory for psychologists. Lawrence Erlbaum Associates Publishers. https://doi.org/10.4324/9781410605269

Glöckner-Rist, A., & Hoijtink, H. (2003). The best of both worlds: Factor analysis of dichotomous data using item response theory and structural equation modeling. Structural Equation Modeling, 10(4), 544-565. https://doi.org/10.1207/S15328007SEM1004_4

Gardner, J., O’Leary, M., & Yuan, L. (2021). Artificial intelligence in educational assessment: ‘Breakthrough? Or buncombe and ballyhoo?’. Journal of Computer Assisted Learning, 37(4), 885-892. https://doi.org/10.1111/jcal.12577

Holland, P. W., & Wainer, H. (Eds.). (2012). Differential item functioning. Routledge. https://doi.org/10.4324/9780203357811

Hambleton, R. K., & Swaminathan, H. (1985). Item response theory: Principles and applications. Springer Science & Business Media. https://doi.org/10.1007/978-94-017-1988-9

Hambleton, R. K., Swaminathan, H., & Rogers, H. J. (1991). Fundamentals of item response theory. Sage. https://archive.org/details/fundamentalsofit0002hamb

Kolen, M. J., & Brennan, R. L. (2014). Test equating, scaling, and linking: Methods and practices. Springer Science & Business Media. https://doi.org/10.1007/978-1-4939-0317-7

Ke, F. R. G. Almond, R. J. Mislevy, L. Steinberg, D. Yan, and D. M. Williamson: Bayesian Networks in Educational Assessment. Tech Know Learn 24, 97–99 (2019). https://doi.org/10.1007/s10758-016-9292-x

Luo, Y., & Jiao, H. (2018). Using the Stan program for Bayesian item response theory. Educational and Psychological Measurement, 78(3), 384-408. https://doi.org/10.1177/0013164417693666

Li, G., Shuai, J., Hu, Y., & Zhang, Y. (2022). DKT-LCIRT: A deep knowledge tracking model integrating learning capability and item response theory. Electronics, 11(20), 3364. https://doi.org/10.3390/electronics11203364

Lane, S., & Raymond, M. R. (2022). Handbook of test development (3ra ed.). Routledge. doi: 10.4324/9780203102961.

Markon, K. E. (2019). Bifactor and hierarchical models: Specification, inference, and interpretation. Annual Review of Clinical Psychology, 15, 51-69. https://doi.org/10.1146/annurev-clinpsy-050718-095522

Millsap, R. E., & Everson, H. T. (1993). Methodology review: Statistical approaches for assessing measurement bias. Applied Psychological Measurement, 17(4), 297-334. https://doi.org/10.1177/014662169301700401

Putka, D. J., & Hoffman, B. J. (2014). “The” reliability of job performance ratings equals 0.52. En C. E. Lance & R. J. Vandenberg (Eds.), More statistical and methodological myths and urban legends (1st ed., pp. 29). Routledge. https://doi.org/10.4324/9780203775851

Reise, S. P., & Henson, J. M. (2003). A discussion of modern versus traditional psychometrics as applied to personality assessment scales. Journal of Personality Assessment, 81(2), 93-103. https://doi.org/10.1207/S15327752JPA8102_01

Reise, S. P., Widaman, K. F., & Pugh, R. H. (1993). Confirmatory factor analysis and item response theory: Two approaches for exploring measurement invariance. Psychological Bulletin, 114(3), 552-566. https://doi.org/10.1037/0033-2909.114.3.552

Thomas, M. L. (2019). Advances in applications of item response theory to clinical assessment. Psychological Assessment, 31(12), 1442–1455. https://doi.org/10.1037/pas0000597

Tsutsumi, E., Kinoshita, R., & Ueno, M. (2021). Deep item response theory as a novel test theory based on deep learning. Electronics, 10(9), 1020. https://doi.org/10.3390/electronics10091020

Van der Linden, W. J. (2019). Handbook of item response theory, three volume set. CRC Press. https://doi.org/10.1201/9781315119144

Wagino, W., Maksum, H., Purwanto, W., Krismadinata, K., Suhendar, S., & Koto, R. D. (2023). Exploring the full potential of collaborative learning and e-learning environments in universities: A systematic review. TEM Journal, 12(3), 1772-1785. https://doi.org/10.18421/TEM123-60

Yan, D., von Davier, A. A., & Lewis, C. (Eds.). (2014). Computerized multistage testing: Theory and applications (1st ed.). Chapman and Hall/CRC. https://doi.org/10.1201/b16858

Add Comment